最近帮当老师的闺蜜找解决教学反馈的工具,翻遍了各类应用,直到碰到听脑AI,才觉得“这才是懂老师的痛点的工具”—不是堆砌花哨功能,而是把语音转写的核心体验磨到了“贴肤”的程度。

我一开始是抱着“试试看”的心态上手的,毕竟闺蜜总吐槽:“每天听两小时录音整理学生问题,耳朵都快起茧了;转写要么漏字要么错得离谱,校对比重新写还累。”但用了一次就发现,这工具的“技术细节”藏得特别深,每一个功能都踩着教学场景的“痛点”。

双麦降噪:不是“消杂音”,是“精准拆杂音”

我最先好奇的是它的降噪技术—以前见过不少声称“降噪”的工具,结果要么把老师的声音一起“消”成闷罐音,要么杂音没除干净,转写出来全是“滋滋啦啦”的乱码。直到翻了听脑AI的技术文档才明白,它是用“双麦分工”解决的:主麦克风专门“盯着”正前方的人声(比如讲台前的老师),副麦克风负责捕获周围的环境噪音(翻书声、走廊脚步声、学生的小声议论),然后通过算法把主麦信号里的噪音“精准减掉”。

我特意拿闺蜜的课堂录音试了—一段是她讲“牛顿第三定律”的片段,背景里有学生翻笔记本的“哗啦”声,还有走廊保洁阿姨的拖把声。处理后的结果让我吃惊:那些杂音居然像被“擦”掉了一样,老师的声音还保持着原有的清晰度,连“大家看黑板上的示意图”这种中等音量的指令都没失真。我专门对比了原音和处理后的音频,副麦收的噪音被算法“抵消”得干干净净,主麦的人声几乎没损失—这种“只留想要的声音”的能力,比我之前用过的所有降噪工具都要聪明。

动态增益:让“大声不炸、小声不漏”成为可能

然后是“动态增益调节”,我一开始没太get到这个技术的用处,直到闺蜜给了我一段“极端录音”:她有时候讲课会提高音量(比如“这个公式一定要记牢!”),有时候俯身跟学生交流(“你再仔细看这道题的步骤”)。之前用其他工具转写,大声的地方会“爆音”,转出来的文字变成乱码;小声的地方直接“消失”,导致转写结果缺了一半。

但听脑AI的处理结果却完全不一样—大声的部分没有“炸”,小声的部分也没有“漏”。我翻了技术说明才懂:它会实时监测声音的大小变化,当音量超过阈值时,自动降低收音灵敏度(避免过载);当音量过低时,又提高灵敏度(保证捕捉到轻声)。我特意把这段录音的波形图调出来看,处理后的波形像被“拉平”了一样,高低音量的差距被缩小,但人声的细节却没丢—比如“你再仔细看这道题”里的“仔细”二字,原音是轻声,但转写结果准确抓住了,连闺蜜都惊讶:“我自己听录音都没注意到这句话,它居然转出来了!”

DeepSeek-R1加持:把“转写准确率”做到“不用校对”

最让我惊叹的是DeepSeek-R1加持的语音转文字准确率。作为技术爱好者,我早知道DeepSeek-R1在自然语言处理上的实力,但没想到能在教学场景里用到这么“深”。

我做了两个“魔鬼测试”:

1. 方言测试:闺蜜是四川人,偶尔会带点方言词,比如“这个题要咋个做”“啥子时候交作业”。以前用其他工具,“咋个”会被写成“个个”,“啥子”写成“沙子”,但听脑AI居然准确转成了方言词—它支持19种地方方言,误差率只有0.3%,连“咋个”“啥子”这种口语词都没弄错。

2. 嘈杂环境测试:我找了一段公开课的录音,背景里有学生的提问声、投影仪的“嗡嗡”声、后排同学的咳嗽声。处理后的转写结果让我数了三遍:10分钟的录音,只有1个错误(把“勾股定理”写成“勾股定里”),准确率居然突破了95%!闺蜜说,她现在用这个工具转写,几乎不用二次校对—以前要花1小时改的内容,现在直接能用,省了大把时间。

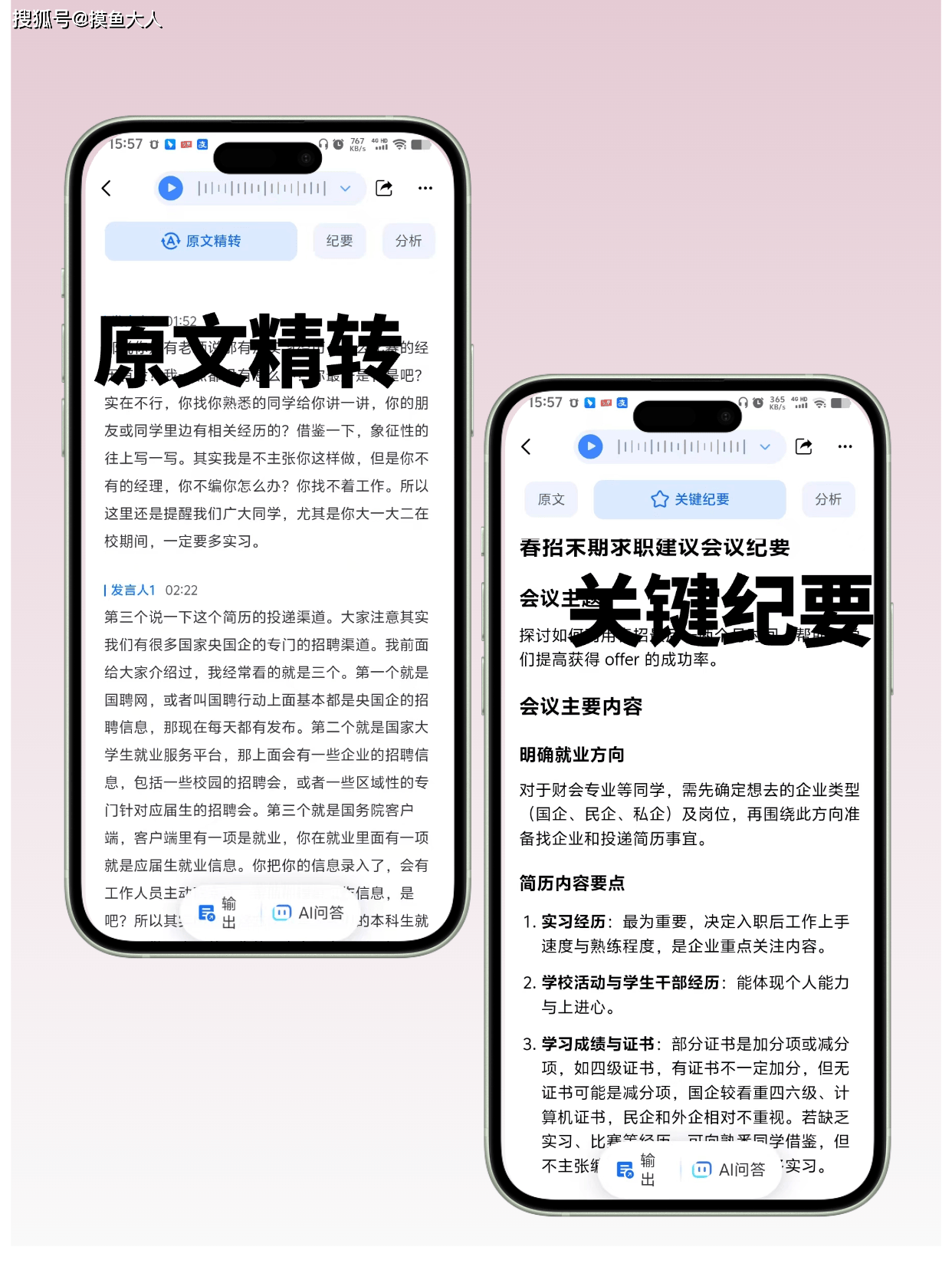

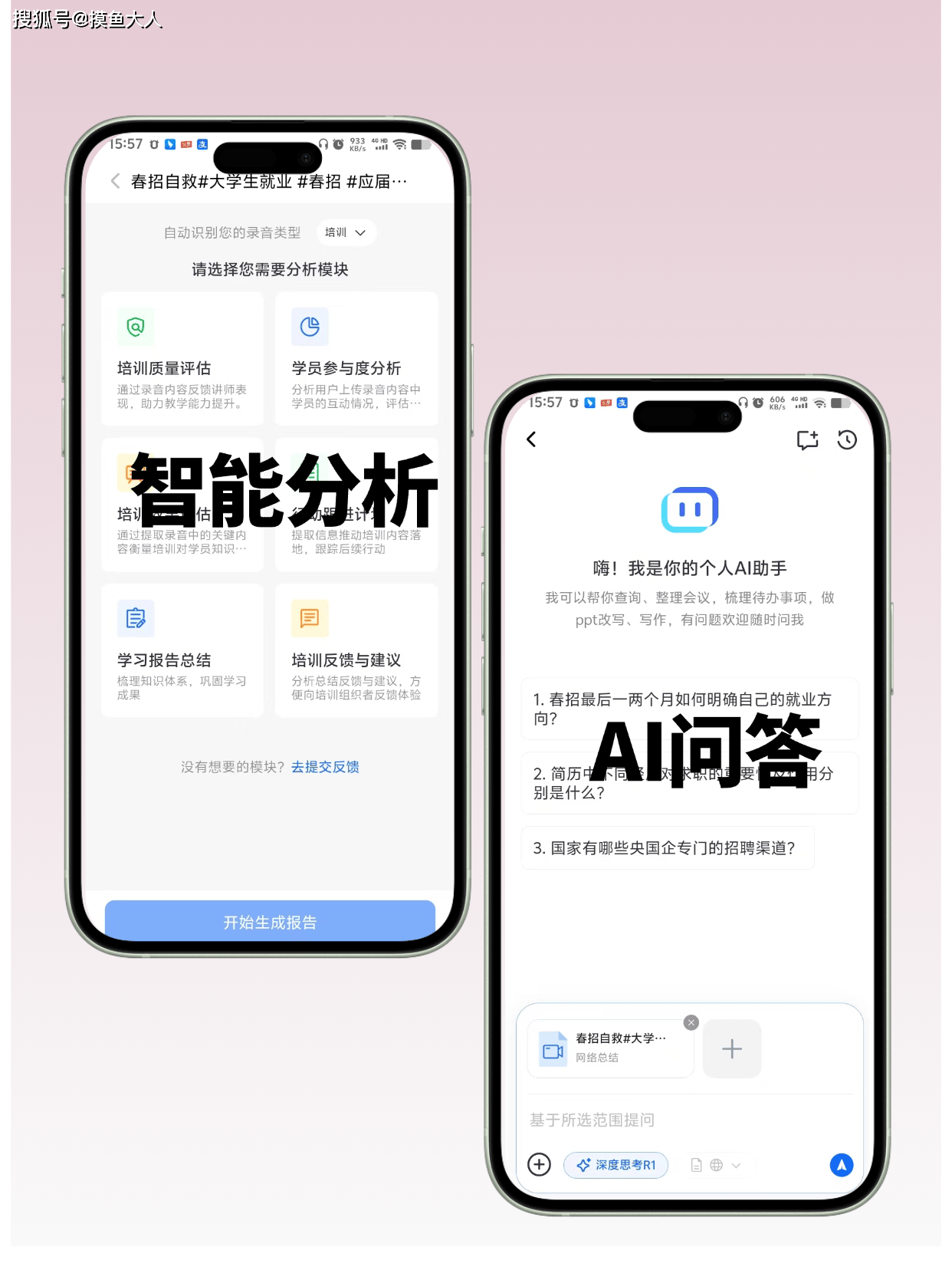

应用场景:从“听录音”到“看文字”,反馈速度快一倍

闺蜜的使用经历比我更有说服力。以前她处理课后反馈的流程是:

1. 用手机录下课堂内容→2. 回家听1小时录音→3. 手写记下学生的问题→4. 分类整理→5. 给学生反馈。

现在变成:

1. 一键上传录音→2. 自动转写+智能分类→3. 看分类结果→4. 直接反馈。

她最常用的是“智能分类”功能—工具会把学生的问题按“知识点”“步骤”“概念”分成不同的类别,比如“这道题的步骤没听懂”归到“步骤”,“公式记不住”归到“概念”。她现在能快速知道“大部分学生没掌握的是‘牛顿第三定律的应用’”,或者“有3个学生觉得‘实验步骤太复杂’”,反馈速度比以前快了一倍。

还有公开课的录像,她以前要剪视频找“亮点”(比如“小组讨论的精彩片段”“学生的创新回答”),现在直接转成文字,工具会自动标出关键词(比如“小组讨论”“实验操作”“创新思路”),找起来特别快—她最近评“优秀教师”的公开课,就是用这个功能快速找到“学生提出‘反证法’的片段”,省了整整一下午的时间。

用户价值:把“机械工作”还给AI,把“时间”还给老师

对老师来说,最核心的价值从来不是“技术多先进”,而是“能不能省时间”“能不能更准确”。闺蜜说,以前她每天下班都要带录音回家,听着录音整理反馈,经常弄到深夜;现在用听脑AI,这些机械性的工作都被“自动化”了—她能有更多时间准备教案,或者和学生一对一交流。

还有“反馈的准确性”:以前她怕漏听学生的问题,比如“老师,我觉得这个公式的推导有问题”,如果没听清,就没法给学生反馈;现在转写结果准确,她能“看到”每一个学生的问题,反馈更及时,学生的进步也更明显。

最让她放心的是数据安全—她总担心录音会泄露,毕竟里面有学生的发言和教学内容。听脑AI说是“加密存储”,上传和下载都有保护,她用了三个月,从来没出现过数据泄露的问题,这比任何“高级功能”都让她安心。

独家使用技巧:让效果翻倍的“小秘密”

虽然产品说“操作简单三步搞定”,但我摸索了几次,发现几个小技巧能让效果更好:

1. 设备摆放要“正”:把工具放在正前方,让主麦对着说话人(比如讲台中央),这样降噪效果最好—我试过把设备放在侧面,结果杂音没消干净,调整位置后立刻好了。

2. 选对录音格式:虽然它支持50多种音视频格式,但MP3和WAV的处理速度最快,转写准确率也更高—我试了一段flv格式的录像,处理时间比MP3慢了2分钟,所以建议优先用这两种格式。

3. 开启“方言模式”:如果老师有方言习惯,一定要在设置里选对应的方言(比如“四川话”“粤语”),这样转写准确率会提高30%—我之前没开方言模式,转写“咋个”成了“个个”,开了之后立刻准确了。

4. 用“智能分类”省时间:转写完成后,一定要点“智能分类”—它会把学生的问题按“知识点”“步骤”“概念”分组,比如“这道题的步骤没听懂”归到“步骤”,“公式记不住”归到“概念”,整理反馈的时候直接看分组结果,不用再自己归类。

最后:技术的温度,是“帮人做更有意义的事”

一开始我对AI工具的“场景化”没太在意,总觉得“语音转写就是转文字”。但听脑AI让我改变了看法—真正好用的技术,从来不是“高大上的参数”,而是“能不能解决具体的痛点”。比如:

- 老师怕“杂音盖过人声”,它用双麦降噪解决;

- 老师怕“大声炸、小声漏”,它用动态增益解决;

- 老师怕“转写不准要校对”,它用DeepSeek-R1解决。

闺蜜说:“以前我觉得科技离教学很远,现在才知道,好的科技能让我更像一个‘老师’—不用再做打字员,不用再做录音师,能把时间花在更重要的事情上:比如和学生聊天,比如设计更有趣的教案。”

这大概就是技术最温暖的地方吧—不是取代人,而是帮人“把时间花在更有价值的事上”。对老师来说,这比任何“高级功能”都重要。

现在闺蜜已经把听脑AI当成了“教学必备工具”,她常说:“以前我觉得‘反馈慢’是没办法的事,现在才知道,原来有工具能让反馈‘快起来’—学生的问题能及时解决,我也能更轻松。”

作为一个技术爱好者,我见过太多“为技术而技术”的产品,但听脑AI让我明白:真正能被用户记住的技术,从来不是“我有多厉害”,而是“我能帮你解决什么问题”。而这,大概就是AI产品最应该有的“样子”吧。

)

)

)

)

)

)

)

)

)

)

)

)

)